来源: GameLook

ChatGPT的开年爆红,迅速引发新一轮的技术浪潮。但同时,AI忧患意识正逐渐在多国蔓延,全球范围内人工智能监管呼声也愈发高涨。

早在3月,生命未来研究所发布了一封集齐了马斯克、图灵奖得主等众多名人签署的公开信《暂停大型人工智能研究》,倡议暂停比GPT-4更强的AI模型的训练,使AI监管进入公众视野。

随后,意大利个人数据保护局宣布暂时禁用ChatGPT,并要求OpenAI对用户信息收集等行为提交改进措施;4月,德国方面表示不排除封禁ChatGPT,法国和爱尔兰开始接触跟进监管,加拿大也宣布对OpenAI展开调查。另据外媒报道,拜登政府已开始研究是否需要对ChatGPT等人工智能工具进行审查。

以月为单位飞速进化的AI,未来会对人类社会产生怎样的影响、又该如何规范相关监管?俨然已经成为全球各国政府、相关领域科学家、以及公众共同关注的话题。不过,在AIGC的监管道路上,中国走在了全球最前列。

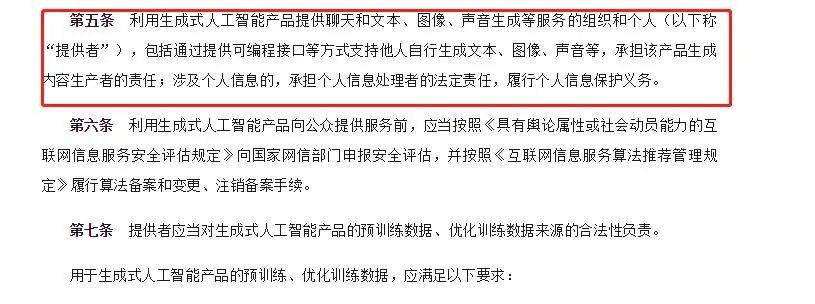

4月11日,网信办发布消息,正式就《生成式人工智能服务管理办法(征求意见稿)》(以下简称为《管理办法》)公开征求意见。虽然空缺了施行的具体月份,但清晰显示为2023年,或意味着中国将成为全球最早实施AIGC相关法律法规的国家。

巧合的是,4月11日中国互联网巨头阿里同一天发布了“通义千问”AI大模型,并宣布阿里旗下所有产品将接入“通义千问”、进行全面改造,类似微软将旗下产品全线整合ChatGPT的操作。而在前一日,商汤科技刚刚发布了“日日新SenseNova”大模型体系;更早些时候,华为还公布了自己的“盘古”。

网信办三个月内发布两版针对AI的管理规定,前后有何不同?

事实上,这并非国内第一次有关于AI技术监管的法律法规出台。早在去年12月,网信办、工信部、公安部联合发布了《互联网信息服务深度合成管理规定》(以下简称《规定》),已经于2023年1月10日正式施行。

时隔三个月,网信办再次发布《管理办法》,进一步增强了对人工智能领域的监管。对比来看,前后两个版出现了哪些不同?

在GameLook看来,首先是名字变化:相比《互联网信息服务深度合成管理规定》提及的“深度合成”,《生成式人工智能服务管理办法(征求意见稿)》直接点名“生成式人工智能”,监管对象的指向性明显更强。从名称上前后表述上的不同,可以看到对技术形态监管定性层面上的升级,而在GameLook看来,这正是源自AI技术的快速提升。短短几个月,无论是监管部门还是普通用户,对于AI的认知和接纳度也在升级。

毕竟去年仅仅是在聊天、合成和生成图片等领域浅尝辄止的AIGC,已经一跃踏入千亿级参数的大模型,甚至已出现超出用户乃至技术人员都难以理解的“涌现”能力(指一个系统复杂到能够出现的全新、意想不到的特性或行为能力)。

如今,相比去年公众对AI的初次接触,AI能力不断提升的同时,热度也在持续发酵。大量开发者、公众尝试后,对人工智能是否可以从原先的低纬度的算法概念、升级为高纬度的“智能”这件事,不再怀疑。因此,对比之前,在AIGC相关法律法规的监管对象上,《生成式人工智能管理办法》选择直接点名就是“人工智能”。

其次是在法规条款的细节程度上:《生成式人工智能管理办法》的条款数、文字量和条款细节度上,暂时落后于年初发布的《深度合成管理规定》。但考虑到这并非最终版,还只是意见稿,之后应该会继续完善。

再从具体条款来看,《深度合成管理规定》发布时,对于AI能否生成代码并不确定,因此暂未提及。而今天发布的《生成式人工智能管理办法》则明确指出“本办法所称生成式人工智能,是指基于算法、模型、规则生成文本、图片、声音、视频、代码等内容的技术”。这意味着,AI生成代码得到认可已经成为新的技术拓展趋势,未来AI生成计算机软件、游戏代码也将成为可能。

短短三个月,两个管理办法对AI能力范围上出现了戏剧性变化,也证明了AI能力提升已经得到主管部门认可。

同时,《管理办法》还对具体的技术细节上提出了要求:“ 提供者应当按照《互联网信息服务深度合成管理规定》对生成的图片、视频等内容进行标识”。增加标识以对创作内容溯源,这与目前海外讨论的监管方向基本一致。

但不同于国外,《生成式人工智能管理办法》首次对AI提出了防沉迷要求:“提供者应当明确并公开其服务的适用人群、场合、用途,采取适当措施防范用户过分依赖或沉迷生成内容”,这一规定可以说是相当超前。

当然,两版管理办法也存在不小的共性。如都强调了对知识产权、以及用户信息等个人隐私的保护……这些都是开发者和创业者最关心的话题。

其中,《生成式人工智能管理办法》进一步规范了AI技术监管,特地提到:面向公众服务的AI产品需要提前备案;而对AI生成的内容,技术服务商几乎要承担“无限连带责任”,包括个人信息的保护义务。换言之,OpenAI、谷歌、阿里、腾讯、商汤等大模型公司开放API接口后,要对调用“GPT类AI能力”的第三方应用的AIGC内容负责。

监管即将落地,对AI创业企业有何影响?

所有人都清楚,站在投资风口的AI相关产业,将成为推动全球经济增长的重要力量。因而在《生成式人工智能管理办法》公布后,外界的第一反应必然是:遭遇监管后,AIGC发展速度是否会由此变慢?

其实在GameLook看来,中国科技领域,没有被“单独立法立规”纳入监管的行业,往往公众影响力和商业规模、商业价值还不够大。

比如以游戏业熟知的剧本杀、盲盒为例、他们在火之前并没有相关的专项管理规定,都是在做大并产生了公众影响力和商业价值后,才纳入了监管范畴。而一些长期冷门的领域,比如桌游、至今主管部门都没有具体的管理规定。

因此再来看AI当前的情况,之所以相关规定法规能够迅速出台,推动中国可能成为全球最早实施AIGC相关法律法规的国家,说明公众、企业界、主管部门自上而下都认可,AI是一个极具发展潜力的新兴科技行业。

正如OpenAI创始人Sam Altman在采访中指出,AI是少有的被严重炒作之后,还被严重低估的东西;比尔·盖茨则强调,AI是他一生中第二次革命性技术进步;英伟达CEO黄仁勋直言:“我们正处于AI的iPhone时刻。”——种种信号表明,当下正是加入AI创业的最佳时机。

从全球范围来看,目前海外知名孵化器Y Combinator的创业营中,来自AI领域的创业公司数量与占比大幅增长,15%的创业公司选择下场AIGC。不过,对中国市场来说,相关领域的AI创业公司还很稀缺。

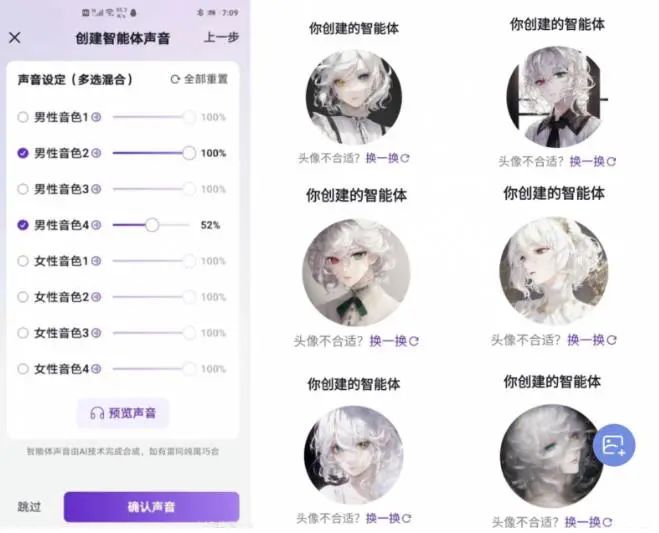

此前据市场传闻,米哈游对中国AI创业公司MiniMax发起两轮投资,并与红杉资本共同策划发起新一轮投资。而Minimax的估值也在半年间飞涨十倍,目前高达10亿美元。然而在融资消息曝光前,这家估值十亿的公司却鲜为人知,甚至像GameLook这样专注于游戏ACG市场的行业垂直媒体此前都没听说过Minimax,这足以说明国内AI创业的确处于早期阶段,优质AI投资标的在国内极为稀缺。

Minimax此前推出的AI聊天类APP“Glow”

今日公布的《生成式人工智能管理办法(征求意见稿)》虽然空缺了施行的具体月份,但已经清晰显示了2023年。结合已经开始实施的《规定》,今年年内可能会有两项AI相关的法律法规落地,那么,这又会对国内AI创业市场带来怎样的影响?

首先是《生成式人工智能管理办法》中提及的AI备案、增加AI生成内容标识、对生成内容负责等具体条例,带来的最直接影响是——AI创业公司团队投入、合规投入的增大。

有关AI的隐私保护、数据安全等内容审核,意味着大量的时间和人力投入,习惯了申请版号的游戏公司、以及互联网平台公司对内容审核最为熟悉。虽然国外比如Meta、Google等也在用AI或者说用算法在做内容自动审核,但依旧不能完全脱离人工内容审核。

因此,短期内面向中国市场的AI创业公司对内容审核团队要求必然会更加迫切,而非外界担心的“AI完全取代人类工作”情况,以AIGC产品内容生成动辄单日百万、乃至千万级的内容量,没准AIGC中国公司要招聘不少内容审核员。

同时,由于两版管理办法都强调公众可以直接举报,并会带来停止服务等相关处罚,影响明显。对于AIGC创业公司来说,未来没有人工团队将会很难运转。面向公众服务的AIGC公司需要立刻建立内容审核团队,快速解决相关备案,完善用户隐私保护等问题。

其次,从AI发展形势来看,未来会出现多种创业方向。如热度最高的千亿参数的通用大模型AI,虽然能够解决很多问题,但由于开发和训练门槛较高,目前进场选手多是中大型的上市公司,且竞争极其激烈。但同时,随着AI大模型公司越来越多,这也能推动为AI提供训练的数据标注、内容版权交易等关联产业,在短期内可预见会出现较大发展,同样会带来数据标注员的大量招聘需求,创造了新的就业。

与之相对,成本更低百亿、乃至几十亿参数量的AI小模型为了不被挤出赛道,则需要在专业度上不断演化。毕竟每个行业都有自己的独特需求,如ChatGPT能够短时间内满足游戏行业需求,但随着一些专用模型的发展,像是Midjourney、Stable Diffusion等专业文本图像生产AIGC的深化,更适用于游戏业这个特定使用场景,其能力也更受游戏开发者青睐。

通过为专业人群提供服务、解决特定行业的特定需求,小模型AI一样存在巨大价值。当然,也不排除未来巨头重点开发垂类AI应用模型的可能性。比如腾讯作为一家在游戏和内容产业深度布局的公司,不排除腾讯的AI大模型会着重在游戏以及音视频领域深度发力,但无论如何,在中国市场AI的合规化将是眼下巨头、以及创业公司需要遵循的首要原则。

游戏业监管已经滴水不漏,AI管理办法出台对游戏业影响有限

对于游戏行业来说,虽然ChatGPT可以转换为智能NPC,或是帮助开发者编写剧情,甚至是有朝一日实现游戏代码、3D模型生成的可能性。但就目前来说,国内这两则AI管理法规对游戏公司的影响却相当有限。

一方面,游戏产业本就拥有相对全面的管理规定和行业法规,监管覆盖了事前、事中、事后多个阶段,不光需要提前申请版号进行游戏内容审核,对于数据安全、隐私保护、甚至是未成年人保护等方面也都有具体要求。长期处于强监管下的游戏业,之前落地的各项监管规定明显比这两则AI管理规定更加完善和具体。

另一方面,两版管理办法的主要对象是对公众提供服务的AI大模型,而游戏企业目前主要在内部使用Midjourney、Stable Diffusion等软件进行AI绘图,且Stable Diffusion大多是在游戏企业的开发机上本地部署安装软件。生成内容也是在企业端使用,并不存在不经内容审核面向公众(玩家)的问题。

不仅如此,ChatGPT级别大模型AI需要超过1万张A100显卡,每训练一次的成本高达1000万美元。而游戏企业使用的免费开源AI模型Stable Diffusion不存在大量算力投入问题,项目开发往往不需要如A100这样的高级显卡,消费级的30系、或者高端点的40系显卡即可初步满足游戏企业日常AIGC生产的算力要求。当然也要看各游戏企业的具体要求,是否需要采用云端GPU集群来做AIGC生成,取决于游戏企业的工作量和效率要求,但本地开发机安装部署Stable Diffusion依旧是主流。

虽然在内容版权管理上,游戏业其也面临和通用型AI一样的困境,但成熟游戏企业内部往往积累了大量有版权的图片、美术资源,能够基于自有知识产权内容进行二次训练,完全合法合规。这就意味着,面对版权保护挑战,游戏企业想要做到严格合规,并不困难。

与此同时,近期Meta大语言模型LLaMA在4chan上“意外泄露”,也让通用AI大模型迎来了“Stable Diffustion开源时刻”,一系列表现出色的ChatGPT开源替代品陆续登场。虽然没有达到千亿参数,但这些AI小模型应对游戏企业常见使用场景的效果不错。

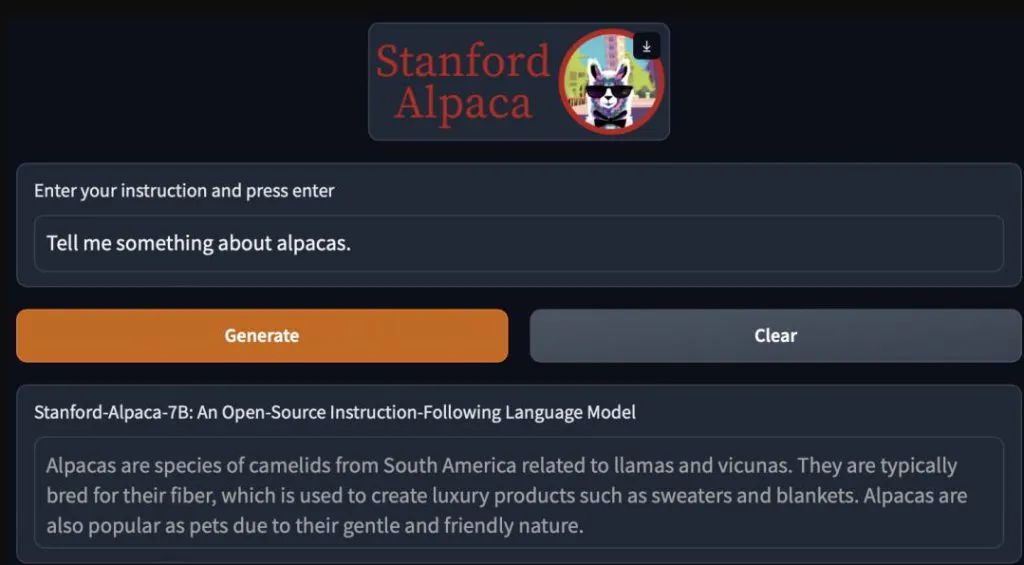

例如,斯坦福发布的大模型Alpaca,仅用了52k数据,且训练成本不到600美元,但性能约等于GPT-3.5;AI风险投资公司Age of AI开发的FreedomGPT,允许用户本地运行LLaMA……其中,Alpaca在与GPT-3.5的比较中,获胜次数为90:89。

同样地,游戏企业本身就有程序员、也有一定可能和意愿对这些开源AI模型进行二次开发,将来能够使用到什么程度,完全取决于游戏厂商的投入。更进一步来看,继Stable Diffusion后,套壳LLaMA的AI模型迎来本地部署,意味着游戏公司的AI模型使用成本几乎归零,迎来了“AI自由”的新时代,或将成为技术革新大潮下最受益的对象之一。

此外,相比这些短期内对游戏业有限影响,GameLook更好奇的是:随着AIGC纳入监管,普通网民都能通过AI进行UGC创作了,那这是否意味着UCG类游戏在中国游戏市场同样可能迎来“解锁”?

个人中心

个人中心 Enjoy后台

Enjoy后台 登出

登出